Das Model Context Protocol (MCP) ist das, was passiert, wenn KI einen universellen Konnektor bekommt — denken Sie an USB-C - aber für intelligente Systeme. Es definiert ein einfaches Client-Server-Protokoll, das es KI-Modellen ermöglicht, auf Tools, Datenquellen und sogar komplexe Workflows über leichtgewichtige, auffindbare und standardisierte Schnittstellen zuzugreifen.1

Dieser Artikel bietet einen Überblick darüber, was MCP ist, wie es funktioniert, warum es für die KI-Entwicklung wichtig ist und den aktuellen Stand seiner Einführung—und vermittelt Ihnen sowohl konzeptionelles Verständnis als auch praktischen Kontext.

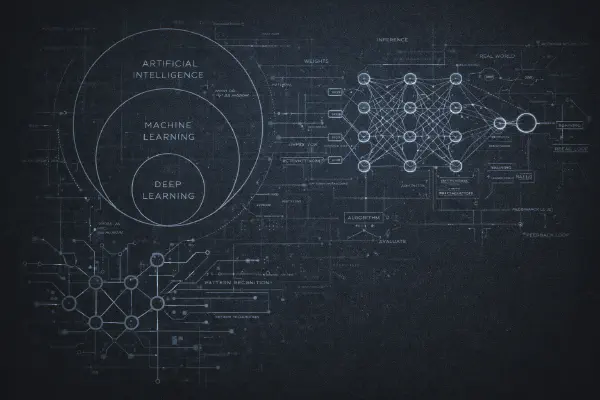

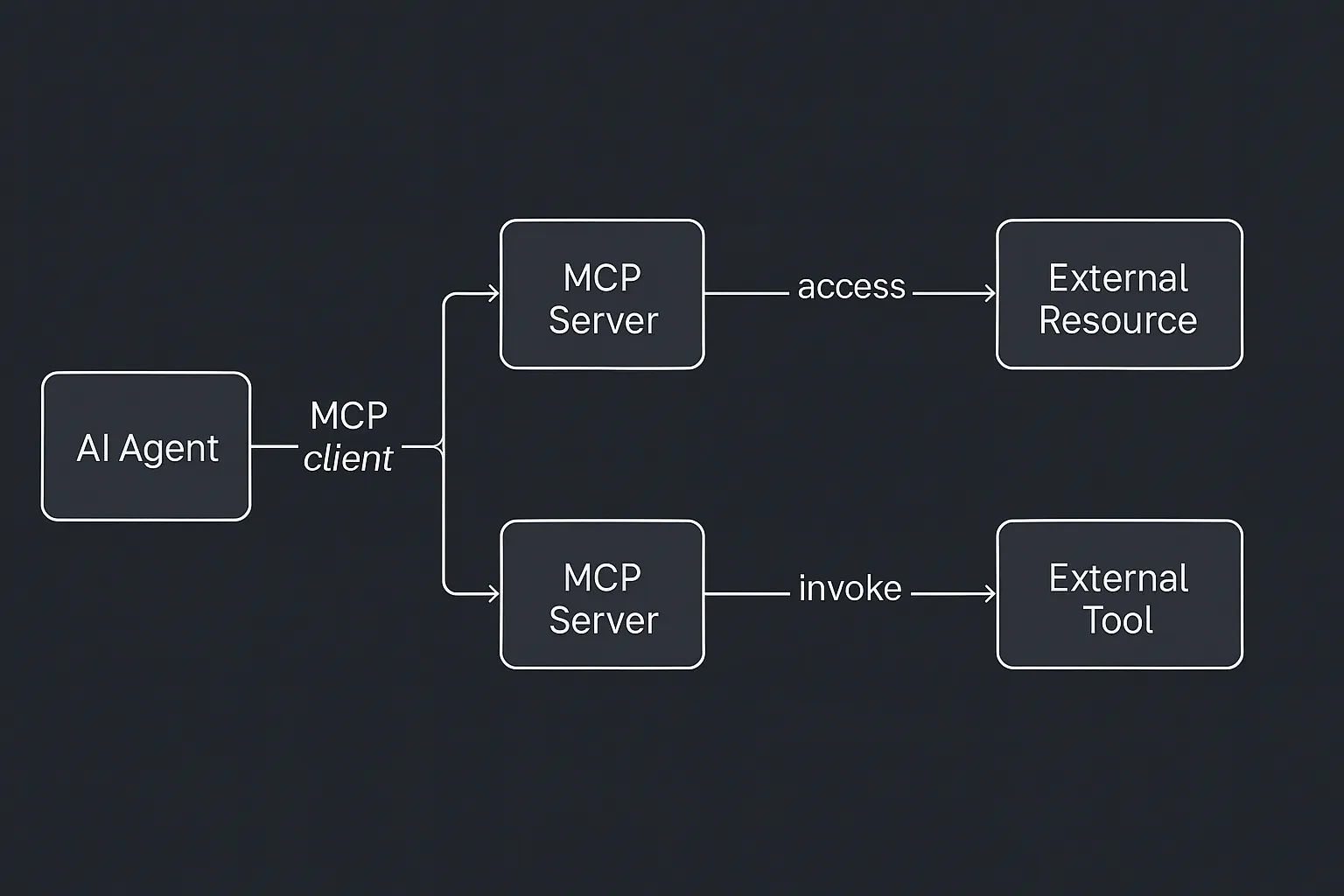

Im Kern definiert MCP (Model Context Protocol) eine konsistente Art für KI-Systeme, mit externen Tools und Datenquellen über ein standardisiertes Protokoll zu kommunizieren. Stellen Sie es sich als eine Schnittstellenspezifikation vor, die KI-Agenten von den Systemen entkoppelt, mit denen sie interagieren. Anstatt jede Integration hardzucoden, definieren Entwickler einen Server, der Funktionalität in einem bekannten Format bereitstellt,2 und KI-Clients (wie Claude, ChatGPT oder ein benutzerdefinierter Assistent) verbinden sich über einen lokalen oder Remote-Stream mit JSON-RPC.2

Das Protokoll dreht sich um ein Client-Server-Modell:

- Der MCP-Client lebt innerhalb der KI-Anwendung. Er verwaltet Verbindungen, Capability-Discovery und Request-Routing.

- Der MCP-Server ist ein eigenständiges Programm (oft ein Microservice oder Container)3, das spezifische Funktionen (“Tools”), Datenquellen (“Resources”) und Anweisungsvorlagen (“Prompts”) in einem Format bereitstellt, das der Client verstehen kann.

Wenn der KI-Agent etwas tun muss—sagen wir, eine Datei nachschlagen, eine Datenbank abfragen oder einen externen Service aufrufen—verwendet er den Client, um eine strukturierte Anfrage an den entsprechenden Server zu senden. Dieser Server führt die Logik aus (wie das Abfragen einer API oder das Scrapen eines Dokuments) und sendet das Ergebnis zurück an den Client, der es in den KI-Kontext injiziert.

Diese Trennung hat weitreichende Implikationen.1 2 Erstens abstrahiert sie die Komplexität externer Systeme vom KI-Modell weg. Zweitens führt sie eine wiederverwendbare, auffindbare Schicht zwischen KI-Logik und Geschäftslogik ein. Und drittens ermöglicht sie Sicherheitsfunktionen wie kontrollierten Zugriff, Authentifizierung und Sandboxing—kritisch, wenn Modellen erlaubt wird, auf externen Systemen zu agieren. Aber vielleicht ist die wichtigste Implikation diese: Der Wert eines KI-Agenten ist direkt an den Kontext gebunden, auf den er zugreifen kann, und die Aktionen, die er ausführen kann. Ein Modell ohne Kontext ist generisch. Ein Modell ohne Schnittstelle ist träge. Was KI wirklich nützlich macht, ist nicht nur Intelligenz, sondern Relevanz—die Fähigkeit, mit bedeutsamen Eingaben zu argumentieren und etwas Bedeutsames als Antwort zu tun.

MCP-Server verwandeln isolierte KI-Modelle in verbundene, leistungsfähige Systeme. Indem sie strukturierten Kontext (über Resources), handlungsfähige Capabilities (über Tools) und strategische Anleitung (über Prompts) bereitstellen, geben sie KI-Modellen die Verankerung und Handlungsmöglichkeiten, die sie brauchen, um in realen Anwendungen tatsächlich Wert zu liefern.

Warum es wichtig ist#

Die meisten KI-Agenten heute leiden unter demselben fatalen Fehler: sie tun nicht viel. Sicher, sie können Fragen beantworten oder Texte schreiben—aber wenn es darum geht, Aktionen auszuführen (eine Datenbank abfragen, eine E-Mail senden, ein Meeting buchen), brauchen sie Hilfe. Die meisten KI-Agenten heute arbeiten wie isolierte Gehirne—intelligent, aber nicht verbunden. Ohne Zugang zu zeitnahen, aufgabenrelevanten Informationen und ohne die Fähigkeit, in der Welt zu agieren, ist ihr Nutzen begrenzt.

MCP ändert das. Es stattet KI mit einer Schnittstellenschicht zu externen Systemen aus, die es Agenten ermöglicht, über Live-Daten zu argumentieren und bedeutsame Aktionen auszuführen. Das verwandelt sie von passiven Beratern in aktive Teilnehmer in Workflows. Es bedeutet, dass Ihre KI nicht nur eine Aufgabe empfiehlt—sie plant sie, protokolliert sie oder erledigt sie mit Ihrem tatsächlichen Stack.

Anatomie eines MCP-Servers#

Jeder Server stellt drei Kernelemente bereit:

- Tools — Funktionen, die das Modell aufrufen kann (wie

send_email,run_query) - Resources — Nur-Lese-Daten, die das Modell in den Kontext laden kann (Dateien, Datensätze)

- Prompts — Vorlagen oder Beispiele, die dem Modell helfen, das Tool effektiv zu nutzen

Diese Struktur gibt der KI eine hochmodulare, inspizierbare Umgebung. Tools können gescoped und versioniert werden. Resources können in Echtzeit aktualisiert werden. Prompts können domänenspezifische Anweisungen tragen, die das Verhalten über Modelle hinweg standardisieren.

Für Leser, die mit technischen Protokollen nicht vertraut sind: JSON-RPC ist ein leichtgewichtiges Nachrichtenformat, bei dem Anfragen und Antworten in JSON strukturiert sind. Es ermöglicht dem Client (KI-Agent), Anweisungen wie “rufe dieses Tool mit diesen Parametern auf” zu senden und ein strukturiertes Ergebnis zurückzuerhalten.

Die aktuelle MCP-Spezifikation verwendet JSON-RPC als Nachrichtenformat, typischerweise übertragen über Streams (z.B. HTTP-Streams, Unix-Pipes oder WebSockets). Zusätzlich sind Authentifizierungs- und Autorisierungsabläufe über OAuth 2.1 standardisiert.

sequenceDiagram autonumber

participant Agent as KI-Agent (Client)

participant Server as MCP-Server

participant Tool as Externes System

Agent->>Server: JSON-RPC-Aufruf

Server->>Tool: API / Tool-Aufruf

Tool-->>Server: Antwort

Server-->>Agent: JSON-RPC-Ergebnis

Und weil alles über ein auffindbares Schema bereitgestellt wird, können selbst neu verbundene Agenten sofort verstehen, was ein gegebener MCP-Server bietet. Dies unterstützt ein Zero-Configuration-Modell, bei dem KI-Agenten sich dynamisch an neue Fähigkeiten anpassen können.

Plug-and-Play-Interoperabilität#

MCP ist offen und modellagnostisch. Das bedeutet:

- Ein GitHub-MCP-Server kann mit Claude, ChatGPT oder jedem anderen Agenten funktionieren.

- Ein Entwickler kann einen Konnektor einmal bauen, und jedes KI-Modell kann ihn nutzen.

- Teams können Tools austauschen oder verketten ohne harte Abhängigkeiten.

Dieses Design fördert einen “einmal schreiben, viele bedienen”-Ansatz. Ein Entwickler kann einen Konnektor für, sagen wir, Notion einmal schreiben—und jeder kompatible KI-Assistent erhält sofort Zugang zu Notion-Funktionen. Es verwandelt Integration in Infrastruktur.

Was bereits passiert#

Seit seiner Open-Source-Veröffentlichung durch Anthropic Ende 2024 hat MCP schnell an Bedeutung in der KI-Branche gewonnen:

OpenAI: Im März 2025 kündigte OpenAI MCP-Unterstützung für seine Produkte an, einschließlich der ChatGPT-Desktop-App und des Agents SDK. CEO Sam Altman hob die Popularität von MCP hervor.4

Microsoft: In Zusammenarbeit mit Anthropic führte Microsoft ein C# SDK für MCP ein, das die Integration mit .NET-Anwendungen erleichtert.5

Google Cloud: Bei Google Cloud Next 2025 stellte Google “Agentspace” und das “Agent2Agent” (A2A) Protokoll vor, das Interoperabilität zwischen KI-Agenten fördert.6

Azure AI: Microsofts Azure AI Agent Service unterstützt jetzt MCP und ermöglicht KI-Agenten den Zugriff auf diverse Datenquellen.7

Enterprise-Adoption: Unternehmen wie Block, Apollo und Sourcegraph haben MCP in ihre Systeme integriert.1

Open-Source-Ökosystem: Die MCP-Community hat über 300 Open-Source-MCP-Server entwickelt, die Integrationen mit Plattformen wie Docker, Gmail, GitHub und PostgreSQL abdecken.8

Diese Adoptionen sind nicht nur theoretisch. Entwickler bei Sourcegraph haben MCP genutzt, um ihrem Cody-KI-Assistenten zu ermöglichen, indexierte Dokumentation und Code-Referenzen auf Abruf abzurufen.

Entwickler Power Move#

Als Builder können Sie jetzt:

- Ihrem Agenten neue Fähigkeiten hinzufügen, indem Sie einen Docker-Container ausführen.3

- Ihren eigenen MCP-Server in Python, JS oder C# schreiben—SDKs existieren für alle wichtigen Stacks.

- Konnektoren remote oder lokal hosten, auf Docker, Kubernetes oder sogar Cloudflare Workers.9

MCP kehrt die Integrationslast um. Anstatt KI-Unterstützung in jedes Tool einzubauen, bauen wir Tools so, dass sie für jede KI zugänglich sind. Das ist ein Game-Changer für kleine Teams oder Indie-Entwickler.

MCP ist kein weiteres Dev-Tool—es ist ein Design Pattern für komponierbare KI.

Strategische Implikationen#

- Standardisierung → Ökosystem: Genauso wie HTTP das Web geschaffen hat, schafft MCP eine gemeinsame KI-Schnittstellenschicht.

- Komponierbare Agenten: Die Ausgabe eines Agenten wird zum Kontext eines anderen, über MCP-Resources.

- Neue Kategorien: Ganze Produkte entstehen als “Agent Hubs” oder “MCP Marktplätze.”

Je mehr Tools MCP sprechen, desto einfacher wird es, sie zu komplexen, agentischen Workflows zu verketten. Stellen Sie sich eine KI vor, die Verkaufsdaten von Salesforce abruft, einen Bericht generiert, ein Slide-Deck erstellt und ein Meeting plant—alles über vernetzte MCP-Server.

Blick nach vorn#

Diese Zukunft zu realisieren erfordert natürlich das Navigieren einiger wichtiger technischer und organisatorischer Überlegungen. Die Integration mit Legacy-Systemen erfordert oft das Wrappen bestehender APIs in konforme MCP-Server. Sicherheit wird ebenfalls entscheidend—das Bereitstellen von Tools und Resources für KI erfordert robuste Authentifizierungs- und Sandboxing-Mechanismen.

Dies repräsentiert auch eine generationelle Chance, ganze Branchen umzugestalten. Von Entwicklertools über Kundensupport bis hin zu Legal-Automatisierung und IT-Operationen—MCP ebnet den Weg dafür, dass KI-native Schnittstellen zur Norm werden.

Und wenn wir noch weiter in die Zukunft blicken, könnte dies das sein, was das traditionelle Konzept einer “App” ersetzt. Anstatt diskrete Anwendungen zu starten, werden Benutzer intelligente Agenten beauftragen, die Workflows dynamisch mit MCP-verbundenen Tools zusammenstellen.

Was werden Sie bauen?#

Wenn Sie 2025 KI-Tools bauen, hardcoden Sie nicht—bauen Sie einen MCP-Server. MCP gibt Ihrem Agenten die Fähigkeit zu agieren, zu skalieren und sich in ein breiteres Ökosystem einzuklinken.

📌 Schauen Sie sich diese Startpunkte an:

Referenzen#

https://techcrunch.com/2025/03/26/openai-adopts-rival-anthropics-standard-for-connecting-ai-models-to-data/ ↩︎

https://visualstudiomagazine.com/articles/2025/04/14/trending-model-context-protocol-for-ai-agents-gets-csharp-sdk.aspx ↩︎

https://www.techradar.com/pro/live/google-cloud-next-2025-all-the-news-and-updates-as-it-happens ↩︎

https://devblogs.microsoft.com/foundry/integrating-azure-ai-agents-mcp/ ↩︎

https://ardor.cloud/blog/early-adopters-mcp-open-source-implementations ↩︎

https://developers.cloudflare.com/workers/tutorials/mcp-servers ↩︎