Model Context Protocol (MCP) est ce qui se passe quand l’IA obtient un connecteur universel — pensez à l’USB-C - mais pour les systèmes intelligents. Il définit un protocole client-serveur simple qui permet aux modèles IA d’accéder à des outils, sources de données et même des workflows complexes via des interfaces légères, découvrables et standardisées.1

Cet article offre un aperçu de ce qu’est MCP, comment il fonctionne, pourquoi il est important pour le développement IA et l’état actuel de son adoption—vous équipant à la fois de compréhension conceptuelle et de contexte pratique.

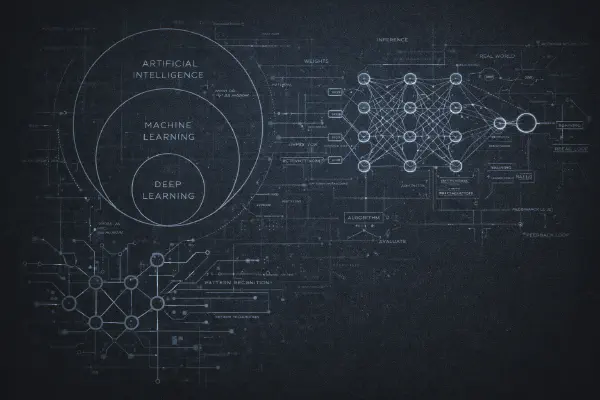

À sa base, MCP (Model Context Protocol) définit une manière cohérente pour les systèmes IA de communiquer avec des outils externes et des sources de données en utilisant un protocole standardisé. Pensez-y comme une spécification d’interface qui découple les agents IA des systèmes avec lesquels ils interagissent. Au lieu de coder en dur chaque intégration, les développeurs définissent un serveur qui expose des fonctionnalités dans un format connu,2 et les clients IA (comme Claude, ChatGPT ou un assistant custom) se connectent via un flux local ou distant en utilisant JSON-RPC.2

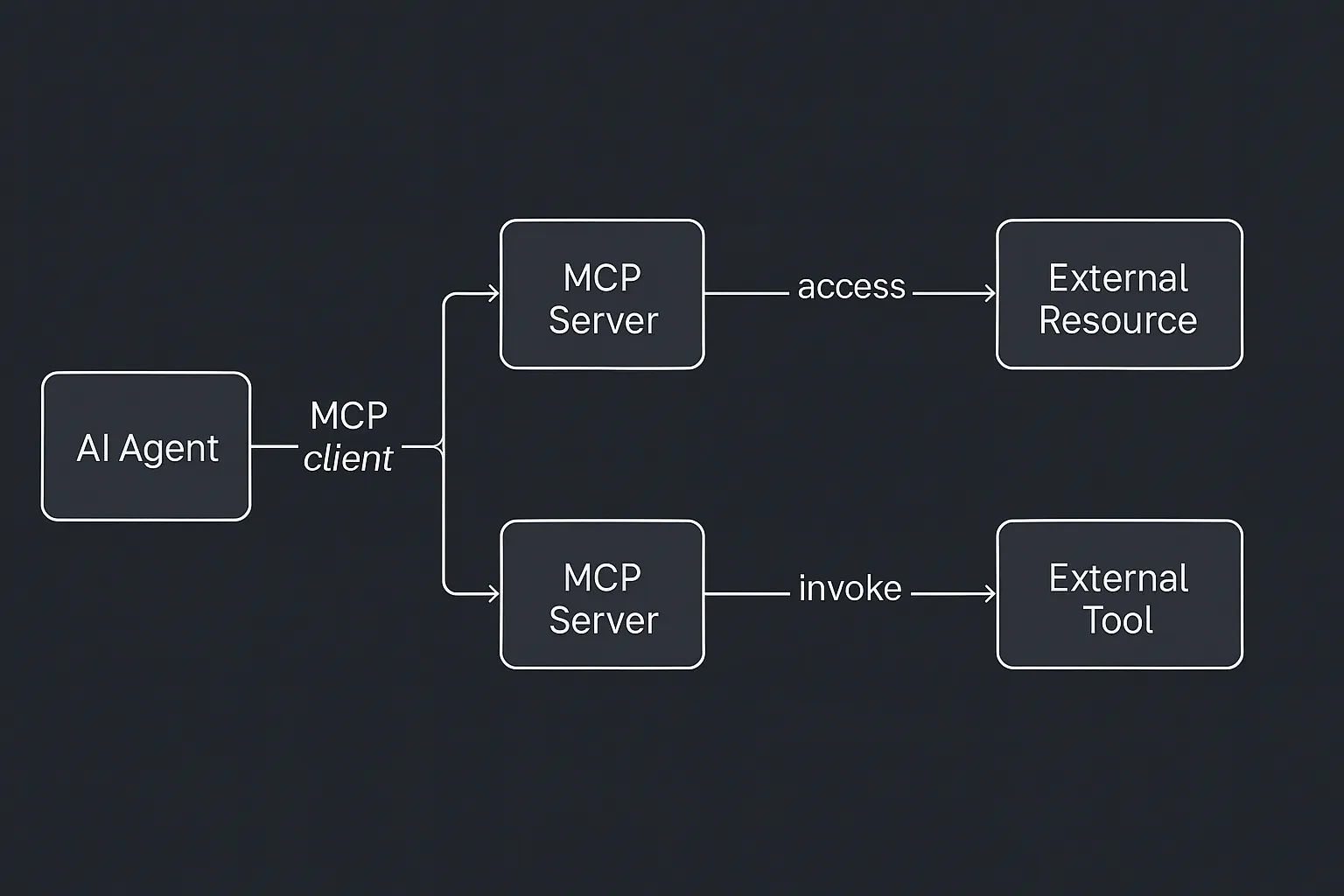

Le protocole s’articule autour d’un modèle client-serveur :

- Le Client MCP vit à l’intérieur de l’application IA. Il gère les connexions, la découverte des capacités et le routage des requêtes.

- Le Serveur MCP est un programme autonome (souvent un microservice ou conteneur)3 qui expose des fonctions spécifiques (“outils”), des sources de données (“ressources”) et des modèles d’instructions (“prompts”) dans un format que le client peut comprendre.

Quand l’agent IA doit faire quelque chose—disons, chercher un fichier, interroger une base de données ou invoquer un service externe—il utilise le client pour envoyer une requête structurée au serveur approprié. Ce serveur exécute la logique (comme interroger une API ou scraper un document) et renvoie le résultat au client, qui l’injecte dans le contexte de l’IA.

Cette séparation a des implications puissantes.1 2 Premièrement, elle abstrait la complexité des systèmes externes du modèle IA. Deuxièmement, elle introduit une couche réutilisable et découvrable entre la logique IA et la logique métier. Et troisièmement, elle permet des fonctionnalités de sécurité comme l’accès contrôlé, l’authentification et le sandboxing—critique quand on permet aux modèles d’agir sur des systèmes externes. Mais peut-être l’implication la plus importante est celle-ci : la valeur d’un agent IA est directement liée au contexte auquel il peut accéder et aux actions qu’il peut entreprendre. Un modèle sans contexte est générique. Un modèle sans interface est inerte. Ce qui donne à l’IA une vraie utilité n’est pas juste l’intelligence, mais la pertinence—la capacité de raisonner avec des entrées significatives et de faire quelque chose de significatif en réponse.

Les serveurs MCP transforment des modèles IA isolés en systèmes connectés et capables. En exposant du contexte structuré (via ressources), des capacités actionnables (via outils) et des conseils stratégiques (via prompts), ils donnent aux modèles IA l’ancrage et les affordances nécessaires pour réellement délivrer de la valeur dans des applications du monde réel.

Pourquoi c’est important#

La plupart des agents IA souffrent aujourd’hui du même défaut fatal : ils ne font pas grand-chose. Bien sûr, ils peuvent répondre à des questions ou écrire du texte—mais quand il s’agit d’agir (interroger une base de données, envoyer un email, réserver une réunion), ils ont besoin d’aide. La plupart des agents IA aujourd’hui fonctionnent comme des cerveaux isolés—intelligents, mais déconnectés. Sans accès à des informations opportunes et pertinentes pour la tâche et sans la capacité d’agir dans le monde, leur utilité est plafonnée.

MCP change cela. Il équipe l’IA d’une couche d’interface vers les systèmes externes, permettant aux agents de raisonner sur des données en temps réel et d’effectuer des actions significatives. Cela les transforme de conseillers passifs en participants actifs dans les workflows. Cela signifie que votre IA ne recommande pas juste une tâche—elle la planifie, l’enregistre ou la complète en utilisant votre stack réel.

Anatomie d’un Serveur MCP#

Chaque serveur expose trois éléments fondamentaux :

- Outils — Fonctions que le modèle peut invoquer (comme

send_email,run_query) - Ressources — Données en lecture seule que le modèle peut charger dans le contexte (fichiers, enregistrements)

- Prompts — Modèles ou exemples qui aident le modèle à utiliser l’outil efficacement

Cette structure donne à l’IA un environnement hautement modulaire et inspectable. Les outils peuvent être scopés et versionnés. Les ressources peuvent être mises à jour en temps réel. Les prompts peuvent porter des instructions spécifiques au domaine qui standardisent le comportement entre les modèles.

Pour les lecteurs non familiers avec les protocoles techniques, JSON-RPC est un format de messagerie léger où les requêtes et réponses sont structurées en JSON. Il permet au client (agent IA) d’envoyer des instructions comme “appelle cet outil avec ces paramètres” et de recevoir un résultat structuré en retour.

La spécification MCP actuelle utilise JSON-RPC comme format de messagerie, typiquement transmis sur des flux (ex. flux HTTP, pipes Unix ou WebSockets). De plus, les flux d’authentification et d’autorisation sont standardisés via OAuth 2.1.

sequenceDiagram autonumber

participant Agent as Agent IA (Client)

participant Server as Serveur MCP

participant Tool as Système Externe

Agent->>Server: Appel JSON-RPC

Server->>Tool: API / Invocation d'outil

Tool-->>Server: Réponse

Server-->>Agent: Résultat JSON-RPC

Et parce que tout est exposé via un schéma découvrable, même des agents nouvellement connectés peuvent immédiatement comprendre ce qu’un serveur MCP donné offre. Cela supporte un modèle zéro-configuration où les agents IA peuvent s’adapter dynamiquement à de nouvelles capacités.

Interopérabilité Plug-and-Play#

MCP est ouvert et agnostique au modèle. Cela signifie :

- Un serveur MCP GitHub peut fonctionner avec Claude, ChatGPT ou tout autre agent.

- Un développeur peut construire un connecteur une fois, et chaque modèle IA peut l’utiliser.

- Les équipes peuvent échanger ou chaîner des outils sans dépendances fortes.

Ce design encourage une approche “écrire une fois, servir plusieurs”. Un développeur peut écrire un connecteur pour, disons, Notion une fois—et chaque assistant IA compatible obtient instantanément accès aux capacités Notion. Cela transforme l’intégration en infrastructure.

Ce qui se passe déjà#

Depuis sa publication open-source par Anthropic fin 2024, MCP a rapidement gagné du terrain dans l’industrie IA :

OpenAI : En mars 2025, OpenAI a annoncé le support MCP pour ses produits, incluant l’app desktop ChatGPT et l’Agents SDK. Le CEO Sam Altman a mis en avant la popularité de MCP.4

Microsoft : En collaboration avec Anthropic, Microsoft a introduit un SDK C# pour MCP, facilitant l’intégration avec les applications .NET.5

Google Cloud : À Google Cloud Next 2025, Google a dévoilé “Agentspace” et le protocole “Agent2Agent” (A2A), promouvant l’interopérabilité entre agents IA.6

Azure AI : Azure AI Agent Service de Microsoft supporte maintenant MCP, permettant aux agents IA d’accéder à diverses sources de données.7

Adoption Enterprise : Des entreprises comme Block, Apollo et Sourcegraph ont intégré MCP dans leurs systèmes.1

Écosystème Open-Source : La communauté MCP a développé plus de 300 serveurs MCP open-source, couvrant des intégrations avec des plateformes comme Docker, Gmail, GitHub et PostgreSQL.8

Ces adoptions ne sont pas que théoriques. Les développeurs chez Sourcegraph ont utilisé MCP pour permettre à leur assistant IA Cody de récupérer de la documentation indexée et des références de code à la demande.

Developer Power Move#

En tant que builder, vous pouvez maintenant :

- Ajouter de nouvelles compétences à votre agent en exécutant un conteneur Docker.3

- Écrire votre propre serveur MCP en Python, JS ou C#—des SDKs existent pour tous les stacks majeurs.

- Héberger des connecteurs à distance ou localement, sur Docker, Kubernetes ou même Cloudflare Workers.9

MCP inverse le fardeau de l’intégration. Au lieu de construire du support IA dans chaque outil, nous construisons des outils accessibles à toute IA. C’est un game-changer pour les petites équipes ou développeurs indépendants.

MCP n’est pas un autre outil dev—c’est un design pattern pour l’IA composable.

Implications Stratégiques#

- Standardisation → Écosystème : Tout comme HTTP a créé le web, MCP crée une couche d’interface IA partagée.

- Agents Composables : La sortie d’un agent devient le contexte d’un autre, via les ressources MCP.

- Nouvelles Catégories : Des produits entiers émergent comme “hubs d’agents” ou “marketplaces MCP.”

Plus les outils parlent MCP, plus il devient facile de les chaîner en workflows complexes et agentiques. Imaginez une IA qui extrait des données de vente de Salesforce, génère un rapport, crée un deck de slides et planifie une réunion—tout via des serveurs MCP interconnectés.

Regarder Vers l’Avenir#

Bien sûr, réaliser ce futur implique de naviguer certaines considérations techniques et organisationnelles clés. L’intégration avec des systèmes legacy nécessite souvent de wrapper des APIs existantes en serveurs MCP conformes. La sécurité devient aussi primordiale—exposer des outils et ressources à l’IA nécessite des mécanismes robustes d’authentification et de sandboxing.

Cela représente aussi une opportunité générationnelle de remodeler des industries entières. Des outils développeur au support client, de l’automatisation légale aux opérations IT—MCP ouvre la voie pour que les interfaces IA-natives deviennent la norme.

Et en regardant encore plus loin, cela pourrait être ce qui remplace le concept traditionnel d’“app”. Au lieu de lancer des applications discrètes, les utilisateurs chargeront des agents intelligents d’assembler des workflows dynamiquement en utilisant des outils connectés via MCP.

Qu’allez-vous construire ?#

Si vous construisez des outils IA en 2025, ne codez pas en dur—construisez un serveur MCP. MCP donne à votre agent la capacité d’agir, de scaler et de se brancher sur un écosystème plus large.

📌 Consultez ces points de départ :

Références#

https://techcrunch.com/2025/03/26/openai-adopts-rival-anthropics-standard-for-connecting-ai-models-to-data/ ↩︎

https://visualstudiomagazine.com/articles/2025/04/14/trending-model-context-protocol-for-ai-agents-gets-csharp-sdk.aspx ↩︎

https://www.techradar.com/pro/live/google-cloud-next-2025-all-the-news-and-updates-as-it-happens ↩︎

https://devblogs.microsoft.com/foundry/integrating-azure-ai-agents-mcp/ ↩︎

https://ardor.cloud/blog/early-adopters-mcp-open-source-implementations ↩︎

https://developers.cloudflare.com/workers/tutorials/mcp-servers ↩︎